Intel Labs американской компании Intel Corp в сотрудничестве с Blockade Labs представили латентную диффузионную ИИ-модель для создания панорамных трехмерных изображений (LDM3D) с 360-градусным обзором, которая первой в отрасли обеспечивает отображение глубины сцены. LDM3D может произвести революцию в создании реалистичного визуального 3D-контента, приложениях метавселенной и цифровом опыте, найти применение в широком спектре отраслей от развлечений и игр до архитектуры и дизайна.

LDM3D была обучена на наборе данных, созданном из подмножества 10 000 образцов базы данных LAION-400M, которая содержит более 400 миллионов пар изображений и подписей к ним. Для отображения точной относительной глубины каждого пикселя была использована разработанная Intel Labs модель Dense Prediction Transformer (DPT). Набор данных LAION-400M создан, чтобы обеспечить возможность широкомасштабного тестирования модели для широкого круга исследователей и других заинтересованных сообществ.

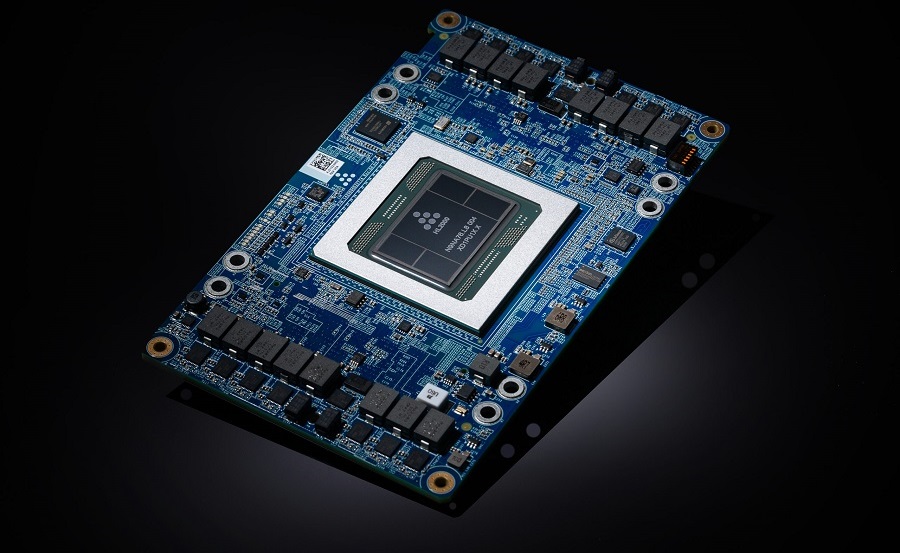

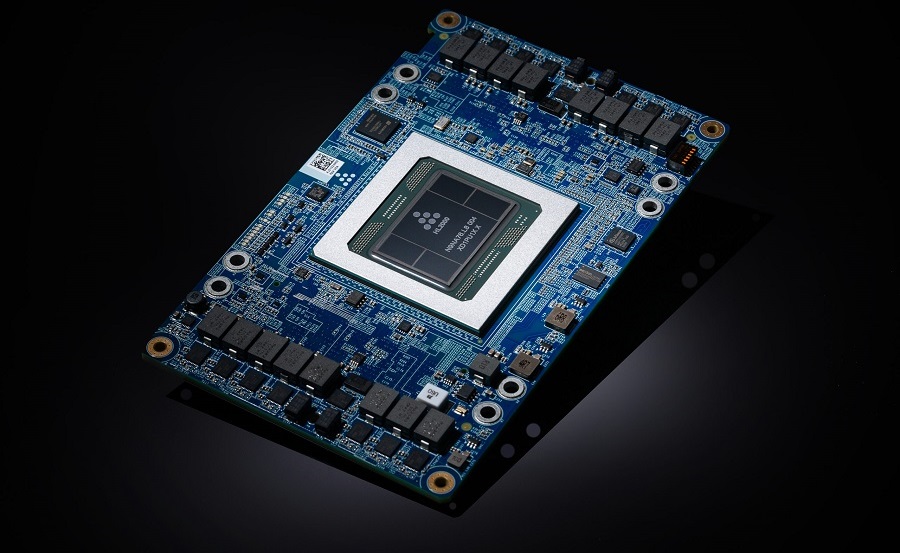

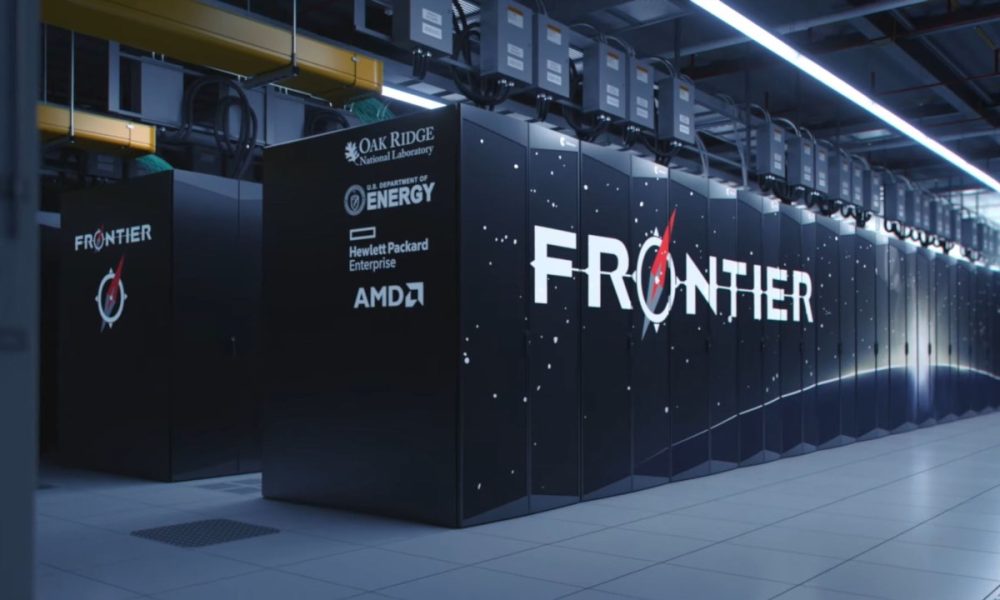

Модель LDM3D обучалась на суперкомпьютере Intel AI на базе процессоров Intel Xeon и ускорителей Intel Habana Gaudi AI. Полученная модель и конвейер объединяют сгенерированное изображение и карту глубины для создания 360-градусных панорамных представлений.

Чтобы продемонстрировать потенциал LDM3D, исследователи разработали приложение DepthFusion, которое использует стандартные 2D-фотографии RGB и карты глубины для создания интерактивной 360-градусной панорамы. Для превращения текстовых подсказок в 3D-панорамы применяется язык визуального программирования TouchDesigner на основе узлов для интерактивного мультимедийного контента в реальном времени. Модель LDM3D объединяет изображение RGB и его карту глубины, что приводит к экономии памяти и ускорению работы.

Это 3D видео, которое вы можете вращать, нажав и удерживая левую кнопку мыши на видео. Желательно развернуть его на весь экран и включить максимальное качество.

"Технология генеративного ИИ направлена на расширение человеческого творчества и экономию времени. Однако большинство сегодняшних моделей ИИ ограничены созданием 2D-изображений. В отличие от них LDM3D позволяет пользователям генерировать изображение и карту глубины из заданной текстовой подсказки. Это обеспечивает более точную относительную глубину для каждого пикселя по сравнению со стандартными методами постобработки и экономит разработчикам значительное время при разработке сцен", пояснил Васудев Лал (Vasudev Lal), научный сотрудник Intel Labs.

Это исследование может революционизировать взаимодействие с цифровым контентом, позволяя пользователям отображать текстовые подсказки ранее немыслимыми способами. Изображения и карты глубины, сгенерированные LDM3D, позволяют пользователям превратить текстовое описание безмятежного тропического пляжа, современного небоскреба или научно-фантастической вселенной в детализированную панораму. Способность создавать карту глубины изображения может мгновенно повысить общий реализм и погружение, позволяя создавать инновационные приложения для различных отраслей, от развлечений и игр до дизайна интерьеров и каталогов недвижимости, а также виртуальных музеев и иммерсивной виртуальной реальности.

Внедрение LDM3D и DepthFusion прокладывает путь к дальнейшему развитию генеративного ИИ и компьютерного зрения. Intel продолжит исследования генеративного ИИ для расширения человеческих возможностей и создания экосистемы разработок в области ИИ с открытым исходным кодом, которая демократизирует доступ к этой технологии. LDM3D предоставляется с открытым исходным кодом через сообщество HuggingFace, а это значит, что в скором времени могут появиться аналоги, взявшие за основу технологию LDM3D.

----------------

Еще почитайте эту тему - https://www.vforum.org/forum/t7075.html. Не забывайте переходить по ссылкам в теме.

LDM3D была обучена на наборе данных, созданном из подмножества 10 000 образцов базы данных LAION-400M, которая содержит более 400 миллионов пар изображений и подписей к ним. Для отображения точной относительной глубины каждого пикселя была использована разработанная Intel Labs модель Dense Prediction Transformer (DPT). Набор данных LAION-400M создан, чтобы обеспечить возможность широкомасштабного тестирования модели для широкого круга исследователей и других заинтересованных сообществ.

Модель LDM3D обучалась на суперкомпьютере Intel AI на базе процессоров Intel Xeon и ускорителей Intel Habana Gaudi AI. Полученная модель и конвейер объединяют сгенерированное изображение и карту глубины для создания 360-градусных панорамных представлений.

Чтобы продемонстрировать потенциал LDM3D, исследователи разработали приложение DepthFusion, которое использует стандартные 2D-фотографии RGB и карты глубины для создания интерактивной 360-градусной панорамы. Для превращения текстовых подсказок в 3D-панорамы применяется язык визуального программирования TouchDesigner на основе узлов для интерактивного мультимедийного контента в реальном времени. Модель LDM3D объединяет изображение RGB и его карту глубины, что приводит к экономии памяти и ускорению работы.

Это 3D видео, которое вы можете вращать, нажав и удерживая левую кнопку мыши на видео. Желательно развернуть его на весь экран и включить максимальное качество.

"Технология генеративного ИИ направлена на расширение человеческого творчества и экономию времени. Однако большинство сегодняшних моделей ИИ ограничены созданием 2D-изображений. В отличие от них LDM3D позволяет пользователям генерировать изображение и карту глубины из заданной текстовой подсказки. Это обеспечивает более точную относительную глубину для каждого пикселя по сравнению со стандартными методами постобработки и экономит разработчикам значительное время при разработке сцен", пояснил Васудев Лал (Vasudev Lal), научный сотрудник Intel Labs.

Это исследование может революционизировать взаимодействие с цифровым контентом, позволяя пользователям отображать текстовые подсказки ранее немыслимыми способами. Изображения и карты глубины, сгенерированные LDM3D, позволяют пользователям превратить текстовое описание безмятежного тропического пляжа, современного небоскреба или научно-фантастической вселенной в детализированную панораму. Способность создавать карту глубины изображения может мгновенно повысить общий реализм и погружение, позволяя создавать инновационные приложения для различных отраслей, от развлечений и игр до дизайна интерьеров и каталогов недвижимости, а также виртуальных музеев и иммерсивной виртуальной реальности.

Внедрение LDM3D и DepthFusion прокладывает путь к дальнейшему развитию генеративного ИИ и компьютерного зрения. Intel продолжит исследования генеративного ИИ для расширения человеческих возможностей и создания экосистемы разработок в области ИИ с открытым исходным кодом, которая демократизирует доступ к этой технологии. LDM3D предоставляется с открытым исходным кодом через сообщество HuggingFace, а это значит, что в скором времени могут появиться аналоги, взявшие за основу технологию LDM3D.

----------------

Еще почитайте эту тему - https://www.vforum.org/forum/t7075.html. Не забывайте переходить по ссылкам в теме.

Комментарий