Оказывается, супер-компьютеры El Capitan и Aurora genAI, со скоростью вычисления 2 экзафлопса каждый, будут не самыми быстрыми компьютерами в мире.

Супер-компьютер американской компании Meta Platforms, Inc для задач в области ИИ крупнейшая на сегодня клиентская система на базе NVIDIA DGX A100 обеспечит производительность в 5 экзафлопс благодаря передовым вычислительным системам NVIDIA, сетевым технологиям InfiniBand и программному обеспечению для оптимизации работы тысяч GPU.

Meta выбрала технологии NVIDIA, чтобы создать самую мощную на сегодня вычислительную систему для задач ИИ.

Анонсированный кластер AI Research SuperCluster (RSC) уже обучает новые модели, продолжая совершенствовать алгоритмы ИИ.

Ожидается, что после полного развертывания Meta RSC станет крупнейшей клиентской системой на базе NVIDIA DGX A100.

"Мы надеемся, что кластер RSC поможет нам создать совершенно новые системы искусственного интеллекта, которые смогут, например, обеспечивать голосовой перевод в реальном времени для больших групп людей, говорящих на разных языках, чтобы они могли совместно работать над исследовательскими проектами или играть в игры с дополненной реальностью", говорится в сообщении компании в блоге.

Обучение самых больших моделей ИИ

Когда RSC будет полностью построен чуть позже в этом году Meta планирует использовать его для обучения моделей ИИ с более чем триллионом параметров. Это может улучшить такие области, как обработка естественного языка, для таких задач, как выявление вредоносного контента в режиме реального времени.

Помимо масштабируемой производительности в качестве ключевых критериев RSC компания Meta назвала исключительную надежность, безопасность, конфиденциальность и гибкость для работы с "широким спектром моделей ИИ".

Кластер RSC от Meta построен на базе сотен систем NVIDIA DGX, объединенных в сеть с помощью коммутаторов NVIDIA Quantum InfiniBand, для ускорения работы команд исследователей.

Под капотом

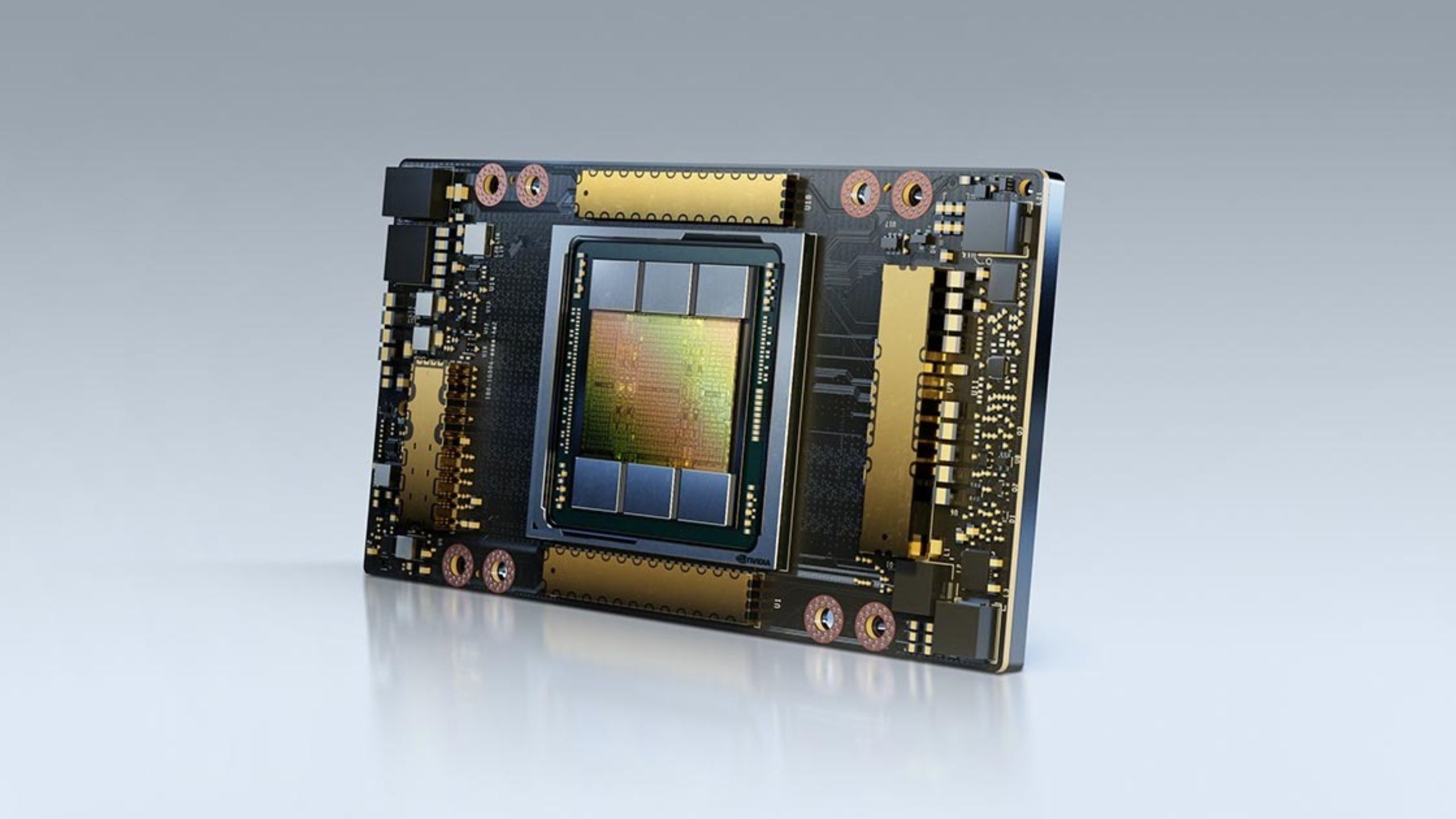

В качестве вычислительных узлов в новом супер-компьютере для ИИ используется 760 систем NVIDIA DGX A100. В общей сложности они содержат 6080 графических процессоров NVIDIA A100, объединенных в сеть с помощью NVIDIA Quantum 200 Гбит/с InfiniBand, что обеспечивает производительность TF32 в 1895 петафлопс.

Несмотря на проблемы, вызванные COVID-19, потребовалось всего 18 месяцев, чтобы перейти от идеи на бумаге к работающему супер-компьютеру для ИИ, в том числе благодаря технологиям NVIDIA DGX A100.

20-кратный прирост производительности

Meta уже во второй раз выбирает технологии NVIDIA в качестве основы для исследовательской инфраструктуры компании. В 2017 году Meta построила первое поколение этой инфраструктуры для исследований ИИ на базе 22 000 графических процессоров NVIDIA V100 с тензорными ядрами, которые ежедневно выполняют порядка 35 000 заданий по обучению ИИ.

Предварительные тесты Meta показали, что RSC может обучать большие NLP-модели в 3 раза быстрее и выполнять задачи компьютерного зрения в 20 раз быстрее, чем система 2017 года.

На втором этапе RSC расширится до 16 000 графических процессоров, которые, по мнению Meta, обеспечат производительность в задачах ИИ в 5 экзафлопс в операциях со смешанной точностью. Также Meta планирует расширить систему хранения RSC до эксабайта при скорости в 16 терабайт в секунду.

Масштабируемая архитектура

Технологии искусственного интеллекта NVIDIA доступны компаниям любого масштаба.

Система NVIDIA DGX, которая включает в себя полный стек программного обеспечения для ИИ от NVIDIA, легко масштабируется от одной системы до уровня кластера DGX SuperPOD, работающего локально или через провайдеров. Клиенты также могут арендовать системы DGX через NVIDIA DGX Foundry.

Так же прочтите эту тему с интересными новостями из мира ИИ - https://www.vforum.org/forum/t7047.html.

О супер-компьютере El Capitan - https://www.vforum.org/forum/t7047-p...tml#post443887.

О супер-компьютере Aurora genAI - https://www.vforum.org/forum/t7047-p...tml#post443916.

Супер-компьютер американской компании Meta Platforms, Inc для задач в области ИИ крупнейшая на сегодня клиентская система на базе NVIDIA DGX A100 обеспечит производительность в 5 экзафлопс благодаря передовым вычислительным системам NVIDIA, сетевым технологиям InfiniBand и программному обеспечению для оптимизации работы тысяч GPU.

Meta выбрала технологии NVIDIA, чтобы создать самую мощную на сегодня вычислительную систему для задач ИИ.

Анонсированный кластер AI Research SuperCluster (RSC) уже обучает новые модели, продолжая совершенствовать алгоритмы ИИ.

Ожидается, что после полного развертывания Meta RSC станет крупнейшей клиентской системой на базе NVIDIA DGX A100.

"Мы надеемся, что кластер RSC поможет нам создать совершенно новые системы искусственного интеллекта, которые смогут, например, обеспечивать голосовой перевод в реальном времени для больших групп людей, говорящих на разных языках, чтобы они могли совместно работать над исследовательскими проектами или играть в игры с дополненной реальностью", говорится в сообщении компании в блоге.

Обучение самых больших моделей ИИ

Когда RSC будет полностью построен чуть позже в этом году Meta планирует использовать его для обучения моделей ИИ с более чем триллионом параметров. Это может улучшить такие области, как обработка естественного языка, для таких задач, как выявление вредоносного контента в режиме реального времени.

Помимо масштабируемой производительности в качестве ключевых критериев RSC компания Meta назвала исключительную надежность, безопасность, конфиденциальность и гибкость для работы с "широким спектром моделей ИИ".

Кластер RSC от Meta построен на базе сотен систем NVIDIA DGX, объединенных в сеть с помощью коммутаторов NVIDIA Quantum InfiniBand, для ускорения работы команд исследователей.

Под капотом

В качестве вычислительных узлов в новом супер-компьютере для ИИ используется 760 систем NVIDIA DGX A100. В общей сложности они содержат 6080 графических процессоров NVIDIA A100, объединенных в сеть с помощью NVIDIA Quantum 200 Гбит/с InfiniBand, что обеспечивает производительность TF32 в 1895 петафлопс.

Несмотря на проблемы, вызванные COVID-19, потребовалось всего 18 месяцев, чтобы перейти от идеи на бумаге к работающему супер-компьютеру для ИИ, в том числе благодаря технологиям NVIDIA DGX A100.

20-кратный прирост производительности

Meta уже во второй раз выбирает технологии NVIDIA в качестве основы для исследовательской инфраструктуры компании. В 2017 году Meta построила первое поколение этой инфраструктуры для исследований ИИ на базе 22 000 графических процессоров NVIDIA V100 с тензорными ядрами, которые ежедневно выполняют порядка 35 000 заданий по обучению ИИ.

Предварительные тесты Meta показали, что RSC может обучать большие NLP-модели в 3 раза быстрее и выполнять задачи компьютерного зрения в 20 раз быстрее, чем система 2017 года.

На втором этапе RSC расширится до 16 000 графических процессоров, которые, по мнению Meta, обеспечат производительность в задачах ИИ в 5 экзафлопс в операциях со смешанной точностью. Также Meta планирует расширить систему хранения RSC до эксабайта при скорости в 16 терабайт в секунду.

Масштабируемая архитектура

Технологии искусственного интеллекта NVIDIA доступны компаниям любого масштаба.

Система NVIDIA DGX, которая включает в себя полный стек программного обеспечения для ИИ от NVIDIA, легко масштабируется от одной системы до уровня кластера DGX SuperPOD, работающего локально или через провайдеров. Клиенты также могут арендовать системы DGX через NVIDIA DGX Foundry.

Так же прочтите эту тему с интересными новостями из мира ИИ - https://www.vforum.org/forum/t7047.html.

О супер-компьютере El Capitan - https://www.vforum.org/forum/t7047-p...tml#post443887.

О супер-компьютере Aurora genAI - https://www.vforum.org/forum/t7047-p...tml#post443916.

Комментарий